Les tests A/B constituent un pilier fondamental de la prise de décision basée sur les données, utilisés pour optimiser aussi bien les designs de sites web que les stratégies marketing.

Cependant, la conception d'un test statistiquement valide et l'interprétation des résultats peuvent s'avérer complexes.

C'est là que l'IA entre en jeu, en proposant une assistance pour automatiser et affiner le processus.

Dans ce tutoriel, vous apprendrez comment tirer parti de Claude, un assistant IA, pour créer des tests A/B bien structurés, analyser les résultats et prendre des décisions éclairées basées sur les données.

À la fin de ce tutoriel, vous aurez acquis les compétences nécessaires pour définir des objectifs de test précis, calculer les tailles d'échantillon requises, concevoir des variations de test efficaces et interpréter vos résultats afin d'apporter des améliorations concrètes.

Objectifs principaux :

- Apprenez à définir des objectifs clairs pour un test A/B.

- Calculez la taille des échantillons et la durée des tests avec l'aide de l'IA.

- Concevez des variantes de test alignées sur les objectifs commerciaux.

- Analysez les résultats des tests A/B en utilisant l'IA pour en tirer des conclusions pertinentes.

- Élaborez un plan d'action basé sur les données à partir des résultats de vos tests A/B.

Définition des objectifs des tests A/B

Tout test A/B réussi commence par des objectifs clairement définis.

Sans cela, vos résultats de test risquent de ne pas correspondre à vos objectifs, ce qui peut entraîner une mauvaise interprétation des données.

Étapes pour définir les objectifs :

Étape 1 : Ouvrez Claude et commencez par définir le projet ou l'objectif. Par exemple, vous pourriez vouloir améliorer les taux de conversion d'une landing page.

Étape 2: Utilisez le prompt suivant :

Tu dois m'aider à réaliser un test A/B pour [décrire brièvement ton projet et ton objectif]. Définis des objectifs clairs, en prenant en compte l'objectif global, l'élément spécifique à tester, les métriques pour mesurer le succès et toutes les contraintes.

Calcul de la taille de l'échantillon et de la durée du test

Une fois les objectifs définis, il est crucial de déterminer la taille appropriée de l'échantillon et la durée du test pour garantir la validité statistique. Effectuer un test avec trop peu d'utilisateurs peut mener à des résultats non concluants, tandis que tester pendant une période trop longue peut gaspiller des ressources.

Utilisez le prompt suivant :

Sur la base de notre objectif de test A/B, aide-moi à déterminer la taille d'échantillon appropriée et la durée du test. Prends en compte les éléments suivants :

1. Notre trafic actuel ou taille de base utilisateurs : [insérer votre estimation]

2. L'effet minimal détectable qui nous intéresse : [insérer le pourcentage, par ex. amélioration de 5%]

3. Niveau de confiance souhaité : [typiquement 95% ou 99%]

4. Puissance statistique : [typiquement 80% ou 90%]

Fournis des recommandations pour :

1. La taille d'échantillon requise pour chaque variation

2. La durée de test estimée basée sur notre trafic/base utilisateurs actuelle

3. Les ajustements à considérer selon notre situation spécifique

Si la durée de test recommandée est trop longue, concentrez-vous sur un segment à fort trafic de votre audience, comme les utilisateurs mobiles ou une région géographique spécifique. Cette stratégie permet d'atteindre plus rapidement une signification statistique, même si cela peut limiter la possibilité de généraliser vos résultats.

Concevoir des variations de tests efficaces

La conception de variations de test efficaces représente le point de rencontre entre créativité et approche scientifique dans les tests A/B. Vous devrez créer différentes versions de l'élément testé tout en maintenant un nombre raisonnable de variations.

Demandez à Claude de suggérer des variations. Par exemple, utilisez ce prompt :

Pour notre test A/B, nous devons concevoir des variations efficaces. Aide-moi à créer ces variations selon les informations suivantes :

1. Notre version actuelle (Contrôle - A) : [décrire la version actuelle]

2. L'élément que nous testons : [par exemple : bouton CTA, titre, mise en page]

3. Nos hypothèses sur ce qui pourrait améliorer la performance

4. Toutes directives ou contraintes de marque à prendre en compte

Fournis :

1. Une description de la version Contrôle (A)

2. 2-3 variations (B, C, D) avec des descriptions claires de leurs différences par rapport au contrôle

3. La justification pour chaque variation, expliquant pourquoi elle pourrait être plus performante

Travaillez avec Claude pour créer 2 à 3 variantes en vous concentrant sur des modifications significatives. Par exemple, changer la couleur ou la taille d'un bouton CTA, ou reformuler un titre pour mieux communiquer la valeur.

En ne testant qu'un nombre limité de variations, vous évitez de diluer votre trafic, ce qui garantit que chaque version obtient suffisamment d'exposition pour une analyse pertinente.

Surveillance et analyse des résultats

Une fois que votre test est en cours, il est essentiel de surveiller attentivement les résultats sans tirer de conclusions hâtives. Une erreur fréquente consiste à arrêter le test dès qu'une variante semble surpasser les autres, mais cela peut conduire à des conclusions peu fiables.

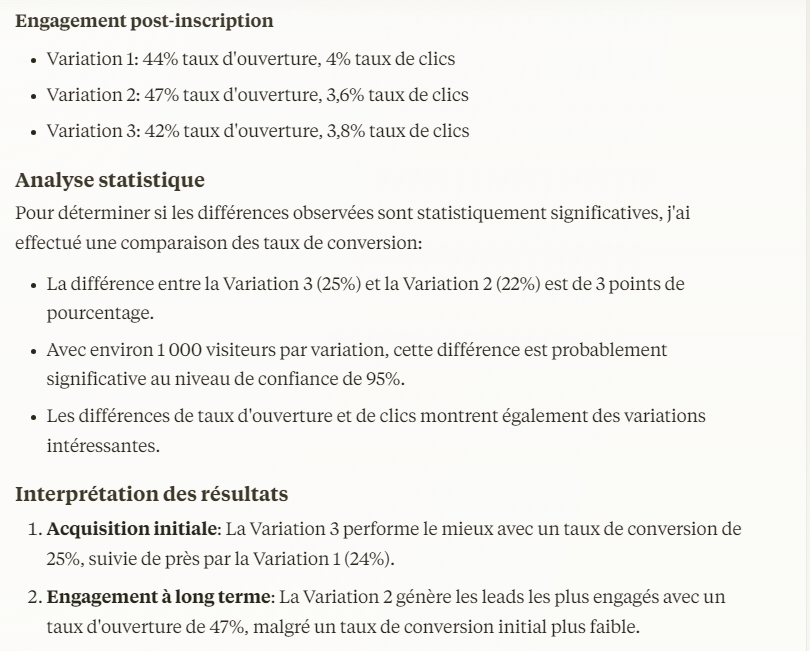

Après avoir collecté suffisamment de données, demandez à Claude d'aider à analyser les résultats.

Prompt :

Analyse notre test A/B avec les métriques suivantes pour chaque variante : [insérer métriques clés]

Claude fournira une analyse de la signification statistique, en déterminant si la différence de performance est significative ou simplement due au hasard.

Ne vous précipitez pas pour terminer le test aux premiers signes d'amélioration. Laissez-le se dérouler pendant toute la durée prévue afin de garantir des résultats stables et représentatifs.

Tirer des conclusions et planifier les prochaines étapes

La dernière étape du processus de test A/B consiste à interpréter les résultats et à les transformer en actions concrètes. Il est essentiel d'avoir une vision globale en prenant en compte tous les indicateurs ainsi que les éventuelles conséquences imprévues de votre test.

Prompt :

À partir de l'analyse de nos tests A/B, aide à résumer les résultats et propose des actions à suivre.

Examinez les recommandations de Claude, qui peuvent inclure la mise en œuvre de la variante gagnante, la réalisation de tests supplémentaires, ou l'exploration des enseignements tirés de différents segments de votre base d'utilisateurs.

Considérations à long terme :

- Le test a-t-il révélé de nouveaux comportements utilisateurs ou des résultats inattendus ?

- Que peut-on améliorer pour les prochains tests ?

- Y a-t-il d'autres segments que vous pourriez cibler pour des expériences complémentaires ?

En documentant les tests réussis comme les échecs, vous constituez une base de connaissances pour vos décisions futures, ce qui permet d'optimiser votre processus de test au fil du temps.

Conclusion

Lorsqu'il est correctement réalisé, l'A/B testing n'est pas un exercice ponctuel mais fait partie d'un processus continu d'optimisation. Grâce à l'IA, vous pouvez effectuer des tests plus intelligents et plus efficaces qui conduisent à des insights exploitables et des décisions fondées sur les données. À mesure que vous poursuivez vos expérimentations, chaque test s'appuie sur le précédent, favorisant une amélioration continue de vos indicateurs clés.

L'intégration de l'IA dans votre processus de test ne fait pas que gagner du temps — elle rend votre stratégie de test plus efficace, vous permettant de prendre des décisions éclairées pour améliorer vos taux de conversion, votre engagement et vos performances globales.

Prochaines étapes :

Utilisez Claude pour concevoir votre propre test A/B en appliquant les principes appris dans ce tutoriel, et continuez à affiner votre approche au fur et à mesure que vous recueillez plus de données et d'enseignements. Avec l'IA à vos côtés, le processus devient plus simple, plus rapide et plus fiable.

.png)

.png)